Esta entrada mucho me temo que tiene demasiada carga teórica. Vamos, un rollo que no veas, pero es que me hace falta porque tengo que refrescar (quizás llegar a comprender de una vez) todo esto y que en alguna ocasión he tenido que enseñar (quizás mal). Allá tú si sigues, porque esto va sobre ese tremendo melón de la Estadística que son los contrastes de hipótesis. Los frecuentistas, los de “toda la vida”. Veremos desfilar a Neyman y Pearson (no el de la correlación, Karl, sino ¡su hijo! Luego me meteré con el padre, por cierto, además de con Galton, porque vaya dos…) y cómo no, a Ronald Fisher.

Por supuesto, y como siempre, mi rollete viene motivado por mi contacto con dos colegas a los que admiro profundamente. Uno es Carlos Gil Bellosta, quien hizo una gran presentación sobre R, Stan y modelos bayesianos en la última reunión del grupo R madRid, y en la misma, además de (literalmente) poner a parir los enfoques fosilizados del contraste de hipótesis, surgió la pregunta de dónde viene ese mito del p = 0.05. Probablemente este sea quizás de uno de los mitos, de los copia y pega ad infinitum, sin contar su origen o el contexto en el que surgen, en toda la estadística y en todas las ciencias experimentales que al final hacen uso de estas técnicas estadísticas.

El otro es Karel quien mantiene un precioso blog, cafecondatos, y que recientemente se enfrascó en esto de los contrastes estadísticos para ver si hay “efecto lunes” en la Bolsa. Me trajo tantos recuerdos que hasta saqué a la palestra al señor Bonferroni y sus correcciones del alfa. Pero el caso es que tuve que repasar otra vez todo el tema de los contrastes, que quizás nunca me quedó claro del todo. Ya, ya, si sé rechazar hipótesis nulas con alegría y sin miramientos, pero ¿qué pasa con eso de la potencia del contraste? Ah, y algo que surgió en la reu. ¿de dónde sale eso del sempiterno 0.05? Y recordé que había leído sobre esto, de hecho lo tuiteé y me repasé creo que dos años de tuits hasta que lo encontré.

Además, el pasado 2015 los p-values estuvieron “en el candelabro”, ¿qué les pasó a los pobres que no les pasara en los 82 años anteriores –artículo de Neyman-Pearson de 1933? Pues entre otras cosas que una revista de Psicología prohibió a sus autores publicar resultados con el infame p-value (qué feo queda decir prohibió, mejor aseguró “descartar”). Vamos, que parecería que en Psicología se van a cargar el p-value y toda la parafernalia estadística asociada no por inanición, no, sino por gula pura y dura.

Aquí tenéis el artículo original, de pago. Pero resultan más interesantes las revisiones de Nature 1 y 2. Resulta que dicen que un contraste con alfa 0.05 “es demasiado fácil de conseguir” y que “se usa a menudo para justificar investigación de baja calidad”. Y yo pienso: ¡pues claro! Porque aceptar un alfa de 0.05 implica que te permites equivocarte en el 5% de tus decisiones, 1 de cada 20 (literalmente lo que dijo Fisher; sigue leyendo si te interesa verlo).

Pero es que resulta que la realidad puede ser muchísimo peor: entre el 50% y el 75% de los resultados experimentales en Psicología social no son reproducibles. Bueno, al menos en Psicología tenemos experimentación porque en otras “ciencias” no, o muchísimo menos.

Por cierto que si hasta Nature se lió con eso de los p-values (baja hasta ver “Clarifications” en 1), qué no les pasará a los estudiantes que se enfrenten a este contubernio. Claro, lo que pasa es que se enseña estadística y experimentación sin hacer ni un simple experimentito replicable y cuando finalmente lo tienes que hacer pues torturas los datos hasta que confiesan, vaya si confiesan, lo que tú quieres. Pero es que leed con un poco de detenimiento los artículos anteriores, o este más sesudo en R-bloggers, ¿explican adecuadamente el procedimiento de Neyman-Pearson? ¿O el de Fisher? Porque, cáspita, no hay una única manera de hacer contraste de hipótesis en estadística. Mi objetivo es intentar comprender al menos los clásicos, los de Fisher y Neyman-Pearson para meterme con ellos (o no).

¡Ah! y no soo los psicólogos nos hemos pasado tres pueblos haciendo contrastes estadísticos “a troche y moche”, hay pecadores a punta pala -mirad aquí o probad a toquetear en esta herramienta interactiva de p-hacking, hasta el punto de que esto de buscar denodadamente que te salga un contraste < 0.05 tiene muchos nombres: Data fishing, snooping o p-hacking.

Así que me planteo intentar responder a estas preguntas: ¿qué culpa tienen los pobres contrastes de hipótesis de que se usen mal? ¿Por qué se ha llegado a esta situación? ¿Algún libro explica suficientemente bien de dónde vienen y en qué contexto se propusieron?

Me serviré de la maravillosa recopilación histórica sobre “la significación estadística” de Arthur Charpentier, que, aunque está en francés y no acabo de leerlo bien, es de lo mejor que he leído al respecto y además incluye fotos (sí, ¡imágenes!) de los libros originales que es algo impagable. Este “artesano del dato” (artisanat de la donnée; preciosa definición de nuestro trabajo) que es Arthur Charpentier, se remonta a s. XVIII, Laplace etc, pero la chicha comienza en el s. XIX.

Cita Arthur a Edgeworth que quería comparar la estatura de criminales frente a población “normal”. Ay estos británicos que querían encontrar la forma de detectar posibles criminales tan simplemente como con la estatura o ¡la cara! El rostro, vamos. Sí, este empeño dio lugar a una de las mayores chaladuras de la pseudo-ciencia, llamada Frenología. Bueno, resulta que este tal Edgeworth se encontró una diferencia de medias de 2 pulgadas (5,08 centímetros), que “excede por bastante 3 veces el módulo de la curva de “normales”, que es 0.2”. Vamos que si eres bajito (y no te digo si eres bajito y feo) puede ser que la líes parda con más probabilidad.

Aquí es donde me doy el gusto de meterme con Galton, Karl Pearson y sí, también con Fisher. Todos ellos catedráticos de eugenesia. Galton en concreto era un racista temible y precursor al menos del lado de la ciencia y el conocimiento de todos los desastres que vinieron posteriormente. Pearson padre y Galton murieron antes de ser testigos de la barbarie nazi, pero Fisher sí fue testigo. Aunque el departamento de Eugenesia del que era profesor se disolvió en 1939, mantuvo sus ideas sobre las diferencias raciales toda su vida. Ojo que la Eugenesia como aplicación de (normalmente) pseudo-ciencia en la sociedad continuó en algunos países hasta la década de los 70 (tomen nota, Suecia y USA, además de Sudáfrica). En fin, del mismo modo que la Física seguro que le debe mucho a la bomba atómica, la Estadística le debe mucho al empeño por “mejorar la raza humana”. Perdonad la digresión pero tenía que hacerla.

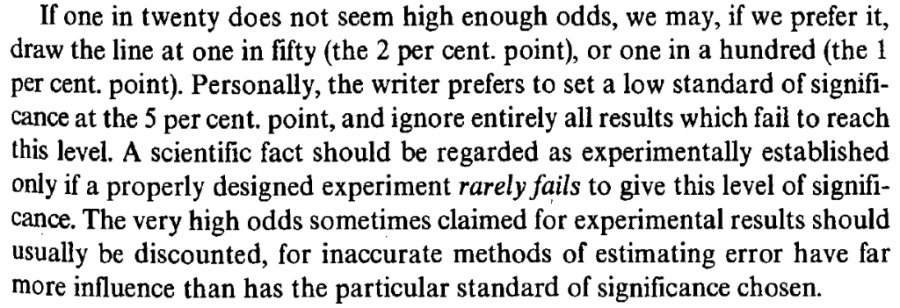

Pero está claro que la gloria estadística de la famosa p es Ronald Fisher. No os perdáis las fotos de los textos reales de Sir Ronald dándole vueltas sobre a partir de qué valor un resultado se puede considerar significativo. Resulta que Fisher tenía una forma de escribir muy discursiva, parecido a lo que hacemos ahora muchos creando tutoriales, y que no hacía definiciones, axiomas o corolarios, así que en una de estas vueltas, y con un criterio ajustado a un contexto muy concreto, el de la investigación agrícola -aquí tenéis el libro completo de 1925 Statistical Methods for Research Workers, se plantea “1 entre 20” como un límite aceptable de error admisible.

Que traducido más o menos sería (perdón que meta mis comentarios entre el texto; total no es un texto sagrado):

“si uno entre veinte (el famoso .05) no parecen posibilidades (“odds”) suficientemente altas, podríamos, si lo preferimos, trazar la línea en uno en cincuenta (.02) o uno en cien (.01). Personalmente el escritor (qué retórico, usa la tercera persona para expresar una opinión) prefiere establecer un umbral bajo de significación en el punto 5% e ignorar enteramente todo resultado que falle al alcanzar este nivel. Un hecho científico debiera ser considerado experimentalmente establecido solo si un experimento adecuadamente diseñado raramente falla en dar este nivel de significación”.

Y estos pensamientos parece que quedaron escritos en piedra, y se repiten en los textos de estadística. Se ignoran muchas muchas cosas que lo rodean: Fisher desarrolló sus trabajos estadísticos, los que más influencia tuvieron (ANOVA, distribución F, primeras versiones de contraste de hipótesis) con datos de explotaciones agrícolas. No parece descabellado plantearse admitir errar el 5% de las veces en este campo, ¿no? Pero imagínese el lector un 5% de fallos en un ensayo clínico de un medicamento con humanos. Y otro punto esencial: el diseño es lo esencial en un experimento, que es lo que hacía Fisher. Exportar estos conceptos a otros campos como sociología, economía, psicología, en los cuales la manipulación experimental es entre difícil e imposible, requiere como mínimo pararse a pensar. Además: Fisher trabajaba con lo que ahora denominamos “small data”, “toy datasets” -uno de ellos el torturadísimo iris, con los que se puede trabajar a mano, porque hay que recordar que ninguno de estos cerebros desarrolló sus trabajos con siquiera una calculadora.

Si leéis con detenimiento los impagables extractos de Arthur Charpentier o la wikipedia sobre la historia de los contrastes estadísticos veréis que la forma de trabajar de Fisher es más sencilla que lo que luego propusieron en 1933 Jerzy Neyman y Egon Pearson. Fisher proponía un mecanismo para poner a prueba una única hipótesis, denominada nula, que puede ser cualquiera siempre que sea exacta. Lo más habitual es que sea una hipótesis de que no hay efectos, diferencias, o que los resultados observados se deben simplemente al azar, pero se puede plantear cualquier hipótesis siempre y cuando tengas un mecanismo estadístico para ponerla a prueba.

Por decirlo de alguna manera, está pensado para descartar resultados (hipótesis nulas) que se deban al azar, y reunir evidencia, que no demostración, de efectos de interés para el investigador.

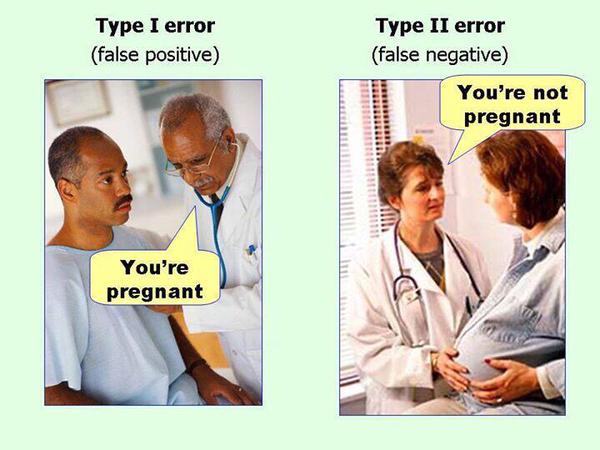

Neyman y Pearson la liaron al introducir posibles hipótesis alternativas, que pueden ser en un sentido u otro (unidireccionales, que el efecto sea mayor o menor) o bidireccionales (que sencillamente hay efecto sin importar para un lado u otro). Y un esquema con dos tipos de error:

- tipo I, que se cometería al rechazar una hipótesis nula cuando es verdadera. Detectar efectos cuando no los hay, o tener un “Falso Positivo”

- tipo II, que se cometería al no rechazar una hipótesis nula cuando es falsa. No detectar efectos cuando los hay, o tener un “Falso Negativo”

Me encanta esta imagen para ilustrar los dos tipos de error:

Y esto es lo que efectivamente hace el esquema de Neyman y Pearson muy completo, al considerar los 4 posibles resultados, y de hecho los errores de tipo I y II son independientes, en este esquema debes jugar con ambos.

Y ahora llegan las letras griegas. Ay, sí, el vicio de los estadísticos.

- alpha es la máxima probabilidad aceptable de cometer un error de tipo I.

- beta es la máxima probabilidad aceptable de cometer un error de tipo II.

Hablando en otros términos, alpha está relacionado con la especificidad de un test, hasta qué punto puedes estar seguro de que cuando detectas un efecto se debe a la manipulación que estás realizando. Beta está en cambio relacionado con la sensibilidad del test, hasta qué punto tu mecanismo permite detectar efectos, diferencias entre un grupo u otro. Otra forma de hablar de ellos:

- alpha es nivel de significación de un test

- 1-beta es la potencia de un test

Dejadme que saque algunas conclusiones preliminares:

- No hay un único esquema de contraste de hipótesis. Hemos planteado dos, uno unidireccional y con hipótesis nula exacta (el de Fisher) y otro más complejo con competencia de diferentes hipótesis (el de Neyman-Pearson). No son lo mismo y debes saber cuándo usar uno u otro. En concreto debes plantearte bien el tamaño del efecto en la hipótesis alternativa para usar adecuadamente Neyman-Pearson. Y de hecho hay más, sobre todo los radicamente diferentes bayesianos. Si no te quieres complicar la vida, puedes usar el de Fisher.

- La Estadística incluso la más básica proporciona más herramientas de investigación: los intervalos de confianza, por ejemplo.

- La capacidad de determinar relaciones causa-efecto con evidencia estadística la da el diseño experimental, no la técnica de contraste de hipótesis.

- El error máximo permitido debe ser establecido antes de las pruebas estadísticas, nunca después.

Y sobre todo, ante todo, el alfa es el error máximo que te permites para toda tu serie de contrastes de hipótesis, poque lo que estás haciendo es fijarte un máximo error permitido, de tal modo que con 0.05 asumes que te equivocarás 1 de cada 20 veces. Así que si repites el ejercicio n veces llegará (¡y rapidísimo!) el momento en que casi seguro que te equivocas en al menos una en tu serie de contrastes.

Y si no mira:

alfa <- .05

n_contrastes <- 1

prob_equiv_al_menos_1_vez <- (1 - (1- alfa)^n_contrastes)

prob_equiv_al_menos_1_vez

## [1] 0.05

for (i in c(1, 5, seq(from = 10, to = 100, by = 10))){

print(paste("Para un alfa de", alfa))

n_contrastes <- i

print(paste("n contrastes =", i, "prob de equivocarte será¡", (1 - (1- alfa)^i)))

}

## [1] "Para un alfa de 0.05" ## [1] "n contrastes = 1 prob de equivocarte será 0.05" ## [1] "Para un alfa de 0.05" ## [1] "n contrastes = 5 prob de equivocarte será 0.2262190625" ## [1] "Para un alfa de 0.05" ## [1] "n contrastes = 10 prob de equivocarte será 0.401263060761621" ## [1] "Para un alfa de 0.05" ## [1] "n contrastes = 20 prob de equivocarte será 0.641514077591458" ## [1] "Para un alfa de 0.05" ## [1] "n contrastes = 30 prob de equivocarte será 0.785361236057063" ## [1] "Para un alfa de 0.05" ## [1] "n contrastes = 40 prob de equivocarte será 0.871487843434897" ## [1] "Para un alfa de 0.05" ## [1] "n contrastes = 50 prob de equivocarte será 0.923055024723287" ## [1] "Para un alfa de 0.05" ## [1] "n contrastes = 60 prob de equivocarte será 0.953930201013048" ## [1] "Para un alfa de 0.05" ## [1] "n contrastes = 70 prob de equivocarte será 0.972416309563225" ## [1] "Para un alfa de 0.05" ## [1] "n contrastes = 80 prob de equivocarte será 0.983484625614986" ## [1] "Para un alfa de 0.05" ## [1] "n contrastes = 90 prob de equivocarte será 0.990111635290341" ## [1] "Para un alfa de 0.05" ## [1] "n contrastes = 100 prob de equivocarte será 0.994079470779666"

Parecerá una locura plantearse ese número de contrastes, pero por ejemplo para hacer todas las comparaciones dos a dos de medias de algo entre lunes y viernes se hacen 10 comparaciones:

combn(c("lunes", "martes", "miércoles", "jueves", "viernes"),

## [,1] [,2] [,3] [,4] [,5] [,6] ## [1,] "lunes" "lunes" "lunes" "lunes" "martes" "martes" ## [2,] "martes" "miércoles" "jueves" "viernes" "miércoles" "jueves" ## [,7] [,8] [,9] [,10] ## [1,] "martes" "miércoles" "miércoles" "jueves" ## [2,] "viernes" "jueves" "viernes" "viernes"

lo cual requiere reducir tu alfa a (1/número de comparaciones) para mantener tu error máximo. Esto es lo que hace Bonferroni, y esto es algo que se ignora de manera sistemática en muchos contextos…

Pero … ¿y qué hacemos con la potencia? ¿Ese Beta vale para algo?

Por hoy ya está bien de tanta teoría. Mañana más…

Oh la lá, así si que mola la estadística. Por fin ya sé a donde tienen que apuntar los links sobre este tema. Muy bueno. 😉

LikeLike

Incorporo aquí algunos enlaces buenísimos que he encontrado mientras preparo la segunda parte de este rollete alfas y betas:

– Post de Daniel Lakens (http://daniellakens.blogspot.com.es/) sobre el incremento de “hallazgos” científicos publicados con alfas entre 0.041 y 0.049. Da que pensar, y apunta a un hecho clarísimo: lo que no resulta significativo, las evidencias en contra de la tradicional hipótesis de que sí habrá algún efecto, *no* se publican, mejor dicho, parece que se publican cada vez menos:

http://daniellakens.blogspot.com.es/2015/02/a-peculiar-surge-of-incorrect.html

(incluye resultados de ciencias sociales, biológicas y físicas; con grandes diferencias entre ellas, claro. Pero fijaos en el disparo en ciencias biológicas http://3.bp.blogspot.com/-CEIYUMBM6Z8/VOMOJPM70YI/AAAAAAAACZs/YUua-MQ-P2k/s1600/Fig9.png)

– Lo estuve buscando para ponerlo *lo primero* pero no lo encontré. Los maravillosos gráficos interactivos (D3) sobre estadística de Kristoffer Magnusson (http://rpsychologist.com/). Este es el *maravilloso* sobre contrastes estadísticos, alfas betas y todas esas gaitas: http://rpsychologist.com/d3/NHST/

LikeLike

Estoy leyendo ahora mismo un reciente informe de la National Academies Press, con el título Statistical Challenges in Assessing and Fostering the Reproducibility of Scientific Results: Summary of a Workshop (2016) , que te puedes descargar gratuitamente de aquí (exige registro pero nada más; no te confundas con el enlace con precio, ese es para comprar el libro impreso):

http://www.nap.edu/catalog/21915/statistical-challenges-in-assessing-and-fostering-the-reproducibility-of-scientific-results

Y leo lo siguiente:

Increasing the Threshold for Scientific Significance

Several speakers (Dennis Boos, Andreas Buja, Steven Goodman, Valen Johnson, and Victoria Stodden) and participants discussed the inadequacy of the current p-value standard of 0.05 to demonstrate scientific significance. Some alternative proposals included reducing the standard p-value (Buja) by at least an order of

magnitude (Johnson), switching to a p-value range (Boos), or switching to a Bayes factor equivalent (Johnson). There was some opposition to changing the standard, specifically due to the possibility that additional resources would be needed to meet the requirement for larger sample sizes.

Así que el tema está candente: hay que revisar esa “manía” del 0.05, quizás reducirlo, y además plantearse aumentar tamaños de muestras porque esa es la consecuencia básica de aumentar especificidad, necesitaremos potencia, aumentar tamaños de muestras (o plantearse experimentos distribuidos y exactamente replicables).

LikeLike

¡Pues sí que está calentito este tema de los p-values, NHST y todo este rollo! Me encuentro hoy con un puñado de enlaces, y me entero además que la ASA (American Statistical Association nada menos) ha manifestado postura oficial para revisar esto del .05

http://amstat.tandfonline.com/doi/pdf/10.1080/00031305.2016.1154108

El comienzo es estupendo:

Q: Why do so many colleges and grad schools teach p = .05?

A: Because that’s still what the scientific community and journal editors use.

Q: Why do so many people still use p = 0.05?

A: Because that’s what they were taught in college or grad school.

He de decir que esta no es la única tautología que encuentras en los libros habituales de estadística. Lo de los niveles de medida es otro “copia y pega” eterno que da lugar a infinidad de confusiones.

Hoy me he vuelto un poco loco en mi twitter (https://twitter.com/ConcejeroPedro) y he comentado al menos estas respuestas o elaboraciones sobre lo de la ASA:

– Estos de DataScienceCentral que por cierto llevan vendiendo su libro la torta, declaran la muerte de p-05, pero no sé para qué, porque proponen usar intervalos de confianza (al 95%) que es más o menos ¡lo mismo! Por supuesto, los intervalos son herramienta más generalmente aplicable que los contrastes, pero se basan en lo mismo!

http://www.datasciencecentral.com/profiles/blogs/the-death-of-the-statistical-test-of-hypothesis

– La polémica en r-bloggers

http://www.r-bloggers.com/its-not-the-p-values-fault-reflections-on-the-recent-asa-statement-relevant-r-resources/

Por cierto excelente lista de R packages for Simultaneous and Selective Inference (“SASI” R packages) -o también, comparaciones múltiples

– Y más comentarios en r-bloggers

http://www.r-bloggers.com/further-comments-on-the-asa-manifesto/

con un ejemplo con dataset movielens que, francamente, no acabo de verlo.

LikeLike